영상 파일은 모두 알겠지만, 카메라가 센서로 받은 색의 정보와 마이크로 기록한 소리를 하나의 파일에 시간의 순서대로 담은 것이다. 그래서 결국 컴퓨터로 다루기 때문에 그때그때 더 효율적으로 파일이 발달해 왔다.

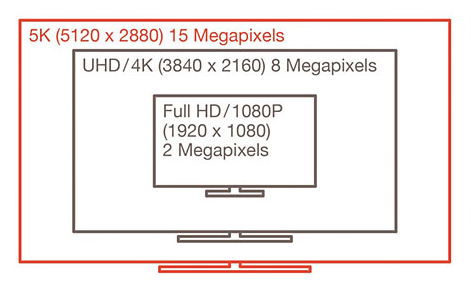

우선적으로 우리가 보는 영상의 화소수 부터 알아보겠다. 여기서 화소수는 화질이 아니다. 화질에는 영상의 선명도와 정확한 색, 주사율등을 따져서 좋은 퀄리티를 화질이 좋다고 하는 것이고 화소수는 이런 것들과 별개로 현재 내가 보고 있는 영상이 얼마나 많은 픽셀 알갱이로 이루어져 있느냐이다. 찍는 영상마다 마구 다른 것이 아니라 애초에 하나로 통일되어 왔다. 누군가는 A로 찍고 보는 사람은 B만 볼 수 있는 환경이라면 서로 호환상의 문제로 영상전달이 제대로 이루어지지 않을 것이다. 그래서 나는 A로 보낼테니 너도 A로 받아서 보고 A를 볼 수 있는 환경을 구축하라고 하는 것이다.

한국이 개발도상국이던 시절, 우리가 보던 TV는 지금의 LCD나 OLED같은 스크린이 아니고 브라운관 TV였는데, 형광물질에 빛을 내는 진공관을 이용해서 색을 표현했다. 실제로 유리를 사용했고 앞뒤로 길어서 무거웠다.

이때 사용했던 공중파 방송이 480p 였다. 세로의 픽셀이 480 개였다.

공중으로 라디오 처럼 뿌려진 전파를 수신해서 시청했기 때문에 낮은 화소수가 적당했다. 지금 우리가 보기에 너무 적은 픽셀이라 low resolution이라고 부르거나 저화질이나 저 화소수라고 부를 수 있다. 하지만 그때만 해도 너무나 적당한 화질이고 그 이상의 품질을 구현한 적도 없고, 곧 발전할거라 생각을 못해서 이것을 스탠더드 데피니션 Standard Definition (SD) 표준화질이라고 부른다. 그 후 HD-High Definition 고화질인 720p로 발전했다. 720p는 DVD영화에 많이 사용되어서 이것을 DVD 퀄리티라고 부르는 사람도 많다. 그 후 1080p 초고화질, Fulll HD 로 발전했다. FHD라고도 부르며 1080을 가끔 HD로 부르기도 하는데 이는 잘못된 표기법이다. 보통 1000 단위를 1K로 표기를 많이 한다. 1000이나 1080이나 반내림할 정도도 안되기 때문에 그냥 1080을 1K대 화질로 본다면 2K는 2000픽셀대 기준이고 4K는 4000 픽셀대 기준이다.

4K를 UHD 울트라 하이 데피니션으로 부르는데 2K도 여기에 포함이 된다. 2K 이상부터는 회사나 사람마다 각기 다르게 부르고, 때문에 정해진 것은 없다. 어차피 K앞에 번호가 붙기 때문에 크게 의미가 있는 것은 아니다. 1080에서 4K로 만들 때 그냥 2000p 4000p로 만들었으면 더 편하지 않았을까라고 생각하는 사람도 있을 것이다. 전 세계가 1080을 사용하는데 갑자기 누가 1000p를 만들고 이것을 사용하자고 한다면 전 세계에 있는 모든 회사들의 이미 투자한 돈과, 기술, 표준, 모든 환경을 전부 다 바꿔야 하는 것이고 80픽셀 줄인다고 더하기 빼기 하는 것이 아니라 기술적으로 인코딩 디코딩에 있어서 또 다른 환경을 처음부터 다시 창조해야 하기 때문에 이루어지지 않는다. 이것이 지구의 종말을 위협하는 것이 아닌 이상 사람들은 기존에 오랜 시간 자리 잡아온 환경을 사용하기 원한다. 그래서 2K나 4K는 1080의 정확히 2배와 4배이다. 1080의 정확한 배가 되는 것이 살짝 다른 비슷한 수의 화소수를 창조해 내는 것보다 기술적으로도 매우 쉽다. 5K도 보면 4K에 720p를 더한 것이다. 하지만 또 8K는 1080의 8배이다. 현재는 기술이 너무 발달했지만 1990년대 나 2000초 만해도 느리고 엄청나게 많은 저장공간을 요구했기에 그 당시 상황에 맞게 발전해 온 것이다

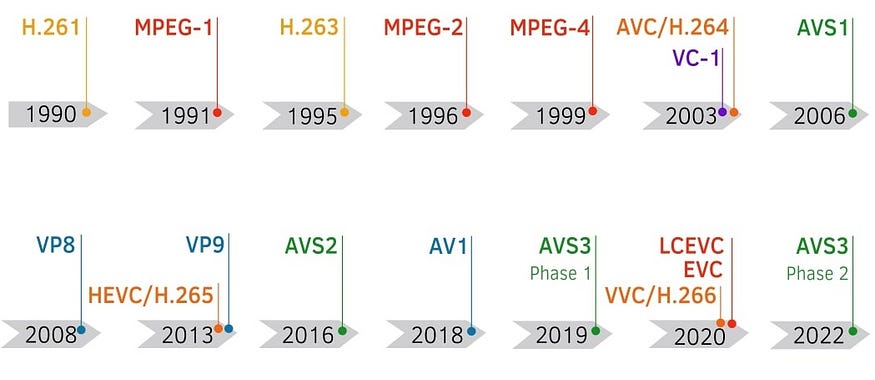

영상이 아날로그이던 시절에는 영상을 편집한다는 개념이 영상속의 그림 1개씩 일일이 편집한다는 개념이 아니라, 현재 재생되어지고 있는, 스트림 되어지고 있는 영상을 녹화하는 개념이었다. 테이프에 녹화하던 시절이었기 때문에 테이프를 자른다고 보는 것이 더 이해가 빠를 것이다. 그래서 이 당시 개발된 영상의 형식은 MPEG1, MPEG2이다. MPEG은 Motion pictures expert group의 약자이고 이것은 영상 포맷을 개발하는 회사이다. 우리도 편집을 할 때 mpeg-2 영상이나 mpeg-4 영상이 버벅 거린다고 느낀다면 그것은 이러한 영상들은 한 프레임 한 프레임 멈춰가며 편집하라고 만들어진 영상이 아니고 스트림용으로 만들어졌기 때문이다. 480 때는 mpeg 1, 2를 사용했고 720으로 화소수가 많아지자 그만큼 데이터 양도 늘어났고, 그래서 보다 효율적이고 용량은 적고 화소수는 높일 수 있는 압축법을 개발한 것이다. 그것이 mpeg-4이다. 720 이후에 1080을 포함한 영상들은 mpeg-4 압축 코덱을 사용했다. 코텍이랑 영상을 렌더링 할 때나 압축할 때 사용하는 소프트웨어 기술이다. 줄여서 mp4라고도 불렀는데 현대에 있어서 MP4는 또 다른 뜻이다. MP4는 영상을 담고 있는 형식을 말한다. 우리가 흔히 말하는 확장자의 개념이 된것이다.

mpeg-4가 꾀 오랫동안 사용되었고 초고화질도 그럭저럭 사용했는데 점차 mpeg-4도 용량이 크다는 말들이 나오고 불편해지기 시작했다. 실제로 1080의 용량이 정말 엄청나게 컸다. 그래서 개발된 AVC/H.264 코덱을 사용했는데 H.264는 같은 화소수 대비 용량이 작고 품질도 우수해서 점차 시장을 장학하기 시작했다. 그 결과 2024년 기준 H.264가 거의 표준이 되었다. 물론 코덱은 이것 말고도 더 많다. 6K, 8K 정도의 영상은 또 다른 고효율 압축이 필요했기에 H.265나 H.266으로 사용도 하지만 이러한 코덱으로 압축을 한다면 플레이할 때도 같은 H.266 디코더가 필요하다.

H.266처럼 높은 압축률을 자랑할수록 불안정성도 존재한다. 그래서 266까지는 아니고 265 정도만 돼도 꾀나 안정적이고 264보다 용량이 적다. 그래서 아이폰이나 갤럭시 폰의 고화질 영상은 H.265나 HEVC라고 하는 걸로 촬영이 가능한데 결국 그냥 다 H.265이다. 가끔 아이폰 영상이 이유 없이 안보이거나 플레이하는데 끈기는 현상이 있다. 265의 불안정성 때문이다. 지금은 많이 해결이 됐지만 그래도 여러 가지 이유에서 264를 많이 사용한다. 요즘 SSD 같은 저장공간의 발달로 인해 264로 생성된 정도의 크기는 너무나 빠르게 복사되고 저장공간도 매우 크기 때문에 264를 사용할 때 오는 작은 단점은 다른 분야의 기술 발달로 인해 사라졌다고 해도 좋다.

아날로그가 거의 사라지다 시피하고 디지털 편집 기반으로 바뀌면서 Apple사에서 개발한 것이 ProRes Codec이다. 프로레스는 일반적인 방송을 기반으로 자리 잡은 코덱들과 결을 달리한다. 아이폰을 만드는 애플에서 개발한 것인데 방송용이 아니라 순수한 현대의 촬영방식과 편집을 위해 개발이 되어서 MPEG이나 H.xxx 계열보다 좋은 품질과 보다 매끄러운 편집 환경을 제공한다. 하이엔드 비디오카메라들은 프로레스 코덱으로 녹화옵션이 있다. ProRes Codec으로 찍으면 H.264 보다 용량이 크게 나온다. 하지만 컴퓨터 편집 시 버벅 거림이나, 실시간 리소스 모니터 등 여러모로 성능이 우월하다. 만약에 카메라에 AVC/H.264와 ProRes 가 있다면 본인의 경우에는 무조건 ProRes를 사용한다. 애플이 의도했는지 모르지만 프로레스의 개발이 영상촬영 편집에 큰 기여를 했다.

촬영을 하고 편집을 할 때는 프로레스로 하고 최종 편집본을 렌더링 걸 때는 H.264로 하면 보다 좋은 품질, 적은 용량을 만들어 낼 수 있다. 다음번에는 영상의 품질 기준이 되는 비트레이트 Bit Rate 과 Color bit, 색의 정확도나 화이트 발란스 등등 이야기 하도록 하겠다.

Make a one-time donation

Make a monthly donation

Make a yearly donation

Choose an amount

Or enter a custom amount

Your contribution is appreciated.

Your contribution is appreciated.

Your contribution is appreciated.

DonateDonate monthlyDonate yearly

Leave a comment